कच्चे डेटा से ANOVA तक: कदम-दर-कदम यात्रा

(From Raw Data to ANOVA: A Step by Step Journey)

16 मिनट पढ़ें ANOVA विश्लेषण के लिए कच्चे डेटा को स्पष्ट, क्रियान्वयन योग्य कदमों के माध्यम से परिवर्तित करने के लिए एक व्यावहारिक मार्गदर्शिका। (0 समीक्षाएँ)

कच्चे डेटा से ANOVA तक: एक चरण-दर-चरण यात्रा

कच्चे डेटा में छिपी कहानी का पर्दाफाश समझदार विश्लेषण की पहचान है। जबकि केवल आँकड़े ही अंतर्निहित पैटर्न के संकेत देते हैं, ANOVA (Analysis of Variance) जैसे सांख्यिकीय तरीके शोधकर्ताओं और पेशेवरों को आत्मविश्वास के साथ महत्वपूर्ण प्रश्नों के उत्तर देने में सक्षम बनाते हैं। चाहे आप उपचारों के बीच रोगी पुनर्प्राप्ति दरों की तुलना कर रहे हों, विभिन्न शाखाओं के लिए ग्राहक संतुष्टि का मूल्यांकन कर रहे हों, या कृषि उपज को अनुकूलित कर रहे हों, ANOVA अवलोकन से ठोस निष्कर्ष तक पहुँचने का एक महत्वपूर्ण द्वार है。

इस गाइड में, चलिए अव्यवस्थित डेटा एकत्र करने से लेकर ANOVA की मदद से स्पष्ट निष्कर्ष निकालने तक की यात्रा समझते हैं। आप कदमों, व्यावहारिक टिप्स, और हर माइलस्टोन पर सामान्य गलतियों को समझेंगे—ताकि आप प्रमाण-आधारित निर्णय ले सकें, केवल शिक्षित अनुमान नहीं。

कच्चे डेटा के परिदृश्य को समझना

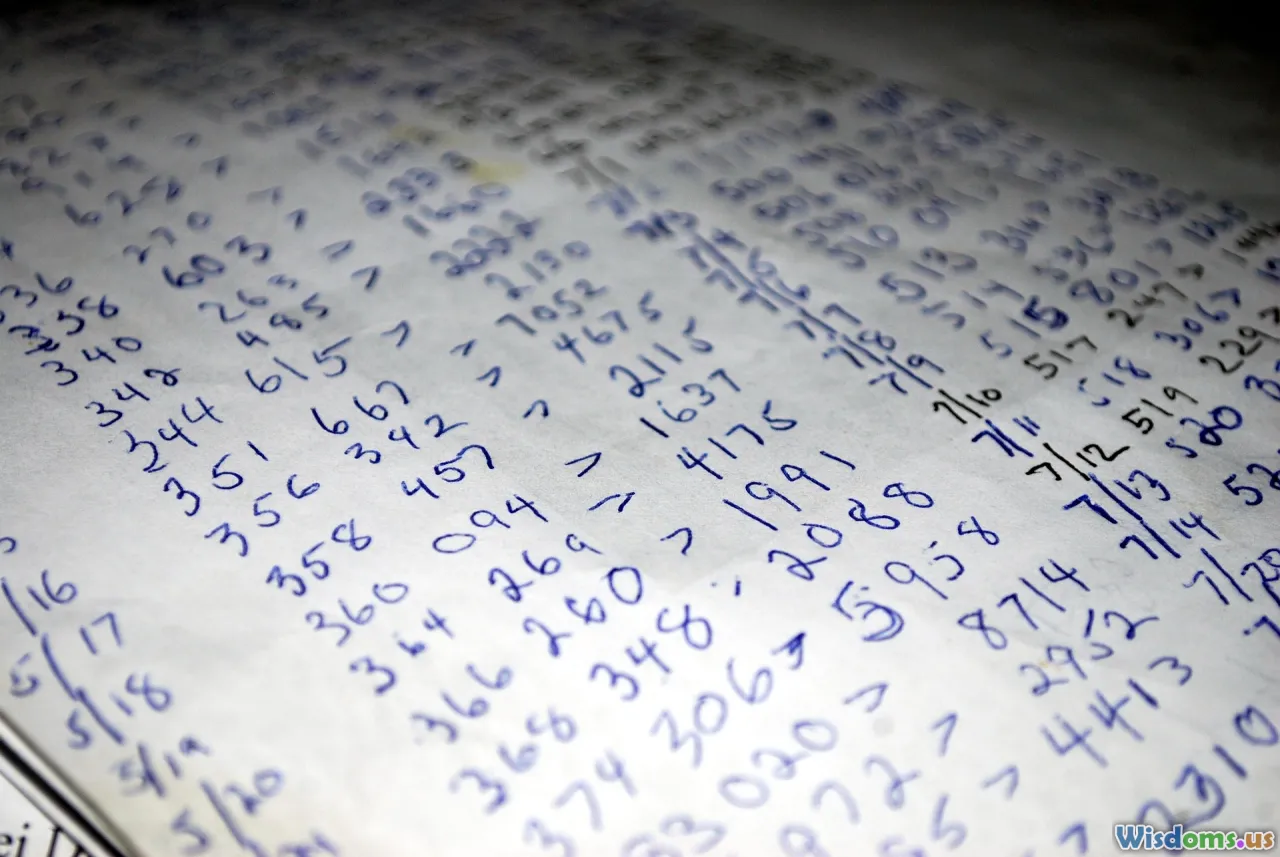

कच्चा डेटा सभी विश्लेषणों की असंरचित/अनगढ़ नींव है। अस्पताल सूचना प्रणाली से ताज़ा निकाला गया डेटासेट सोचिए: रोगी IDs, उपचार समूह, परिणाम माप, और संभवतः कुछ फील्ड मिसिंग हो सकते हैं। यह अव्यवस्थित, अस्वच्छ है, और फिर भी संभावनाओं से भरा है。

ठोस उदाहरण: सर्वेक्षण प्रतिक्रियाएं

मान लीजिए आपको तीन शिक्षण विधियों की प्रभावशीलता का विश्लेषण करना है। किसी स्कूल में हर छात्र एक पद्धति के बाद एक क्विज़ पूरा करता है। उनकी कच्चे स्कोर, यह देखते हुए कि किस पद्धति ने उन्हें चुना, आपके आरम्भिक डेटासेट होंगे। डेटा तालिका कुछ इस तरह दिख सकती है:

| Student_ID | Method | Score |

|---|---|---|

| 1 | Interactive | 78 |

| 2 | Lecture | 68 |

| 3 | Online | 74 |

| … | … | … |

क्रियात्मक सलाह:

- डेटा अखंडता बनाए रखें; raw चरण में मैन्युअल छेड़छाड़ से बचें。

- फ़ाइलें CSV या XLSX जैसे मानकीकृत फ़ॉर्मैट में सहेजें。

- स्रोत, संग्रह तिथि, और चर के अर्थ का दस्तावेजीकरण करें。

Pitfalls:

- Missing documentation या असामान्य संक्षेपण से डेटा का विश्लेषण बाद में कठिन, या असंभव हो सकता है。

- इकाइयों का ट्रैक न रखना downstream में महत्वपूर्ण त्रुटियाँ ला सकता है。

Preparing and Cleaning Data

किसी भी सार्थक विश्लेषण से पहले, raw डेटा को कठोर सफाई की ज़रूरत होती है। यह चरण सटीकता, विश्वसनीयता, और उपर्युक्त सांख्यिकीय तकनीकों के लिए तत्परता सुनिश्चित करता है, खासकर ANOVA, जो आउटलायर्स, गायब मानों, और त्रुटिपूर्ण प्रविष्टियों के प्रति संवेदनशील है。

Data Cleaning Steps:

-

Identify and Handle Missing Values

उदाहरण के तौर पर, अगर किसी छात्र ने क्विज़ नहीं दिया, तो उसकी पंक्ति चिह्नित करें, और तय करें: बहिष्कृत करें या इम्प्यूट करें? -

Detect and Correct Outliers

0 या 110 जैसे स्कोर (जब क्विज़ 100 अंकों का हो) पर जाँच करनी चाहिए。 -

Standardize Categories

यह सुनिश्चित करें कि 'interactive', 'Interactive', और 'INT' एक ही शिक्षण पद्धति दर्शाते हैं。 -

Remove Duplicates

आकस्मिक तौर पर दर्ज रिकॉर्ड तुलनात्मक विश्लेषणों को निराशाजनक रूप से विकृत कर सकते हैं。

Example with Python:

import pandas as pd

df = pd.read_csv('quiz_scores.csv')

# Check missing values

print(df.isnull().sum())

# Remove duplicates

df = df.drop_duplicates()

# Fix inconsistent labels

df['Method'] = df['Method'].str.capitalize()

Key Takeaway: Cleaning is often 60–80% of the entire analytics process. Compromising here weakens everything that follows。

Structuring Data for ANOVA

Not all data formats are ready for ANOVA. Usually, ANOVA (especially one-way) demands a clear categorical group variable and a numerical dependent variable. Preparing data structure properly avoids costly reruns and failed tests。

Example:

To compare means across teaching methods, data should resemble:

| Method | Score |

|---|---|

| Interactive | 78 |

| Lecture | 68 |

| Online | 74 |

You don't need separate columns for each group—long format (above) is preferred for statistical libraries in R, Python, and SPSS。

Tips:

- Ensure your grouping variable is categorical ('Lecture', 'Online', etc.), not numeric codes without documentation.

- Check that each group has an adequate sample size; extremely small groups undermine statistical power.

- Use exploratory data analysis (box plots, histograms) to visualize distributions and spot inconsistencies.

Pitfall: Attempting ANOVA with improperly structured data—like wide-format sheets or mixed-typed variables—leads to syntax errors, messy output, and unreliable results。

Assessing Assumptions Before Analysis

ANOVA’s power hinges on certain assumptions about your data. Ignoring these guards can yield misleading conclusions。

The Three Core Assumptions

- Independence: Observations in each group must be independent. In our quiz example, one student's performance shouldn't affect another's。

- Normality: Scores within each group should follow a normal (bell curve) distribution。

- Homogeneity of variances: Each group’s scores should have similar spread (variance)。

How to Test Assumptions

- Normality: Employ Shapiro-Wilk test (or Kolmogorov-Smirnov if sample is large) for each group. Visual inspection via Q-Q plots helps。

- Homogeneity: Levene’s test (widely used; robust to non-normality). A high p-value supports the assumption。

- Independence: Typically baked into study design (random assignments)。

Practical Application with Python:

from scipy import stats

# Normality

for method in df['Method'].unique():

print(stats.shapiro(df[df['Method'] == method]['Score']))

# Variance homogeneity

from scipy.stats import levene

groups = [df[df['Method']==m]['Score'] for m in df['Method'].unique()]

print(levene(*groups))

Why it matters: By validating assumptions upfront you'll either proceed, adapt your method (e.g., use Kruskal-Wallis test if normality fails), or redesign your experiment—saving effort and credibility。

Conducting the One-Way ANOVA Test

With clean, well-structured data and satisfied assumptions, we proceed to the heart—the one-way ANOVA test. This technique determines if at least one group’s mean differs significantly from the others。

The Mechanics of ANOVA

The core idea: analyze variability between groups versus within groups. If the difference between groups dwarfs individual variability, it’s evidence that the group variable (say, teaching method) actually affects scores。

Mathematically:

- Between-group variance (MSB): Variance of group means from overall mean, weighted by group size。

- Within-group variance (MSW): Variability in scores within each group。

- F-statistic: Ratio of MSB to MSW. Higher F = more likely means differ truly, not by chance。

Example Calculation on Teaching Methods

Suppose the group means are:

- Interactive: 82

- Lecture: 69

- Online: 75

Variance within each group has been found. An F-statistic is calculated, and compared to a critical value from the F-distribution. If the resulting p-value < 0.05, the difference is considered significant。

Real-World Execution (Python):

from scipy.stats import f_oneway

f_val, p_val = f_oneway(

df[df['Method'] == 'Interactive']['Score'],

df[df['Method'] == 'Lecture']['Score'],

df[df['Method'] == 'Online']['Score']

)

print('F-statistic:', f_val, 'p-value:', p_val)

If p-value is 0.003—well below the typical significance level of 0.05—you have strong evidence teaching method impacts student outcomes!

Caveats:

- ANOVA tells if there's a difference, not where it lies.

- Doesn’t handle several independent variables (that’s for factorial or two-way ANOVA).

Traversing Post Hoc Analysis

A significant ANOVA result triggers a natural next question: which group means differ? This is where post hoc tests step in, guarding against "false positive" pairwise differences。

Common Post Hoc Tests

- Tukey’s Honest Significant Difference (HSD): Ideal when group sizes are equal。

- Bonferroni Correction: Simple, conservative; divides significance threshold by the number of comparisons。

- Scheffé’s Test: Used for unequal variances and larger set of combinations。

Python Implementation Example (Tukey HSD):

import statsmodels.stats.multicomp as mc

comp = mc.MultiComparison(df['Score'], df['Method'])

tukey_result = comp.tukeyhsd()

print(tukey_result)

Tukey’s HSD result might show:

| Comparison | Mean Diff | p-Value |

|---|---|---|

| Interactive-Lecture | 13.0 | <0.001 |

| Interactive-Online | 7.0 | 0.04 |

| Lecture-Online | 6.0 | 0.20 |

So, Interactive method significantly outperforms Lecture and Online, but Lecture vs. Online isn't significantly different。

Insights:

- Post hoc transparency is vital for actionable outcomes and reporting.

- Overusing post hoc tests inflates Type I error (false hope!), which is why corrections are applied。

Reporting and Visualizing Results

Statistical outcomes gain power when reported with clarity and compelling visuals. Stakeholders often need both the big picture and actionable detail。

Key Elements of a Report

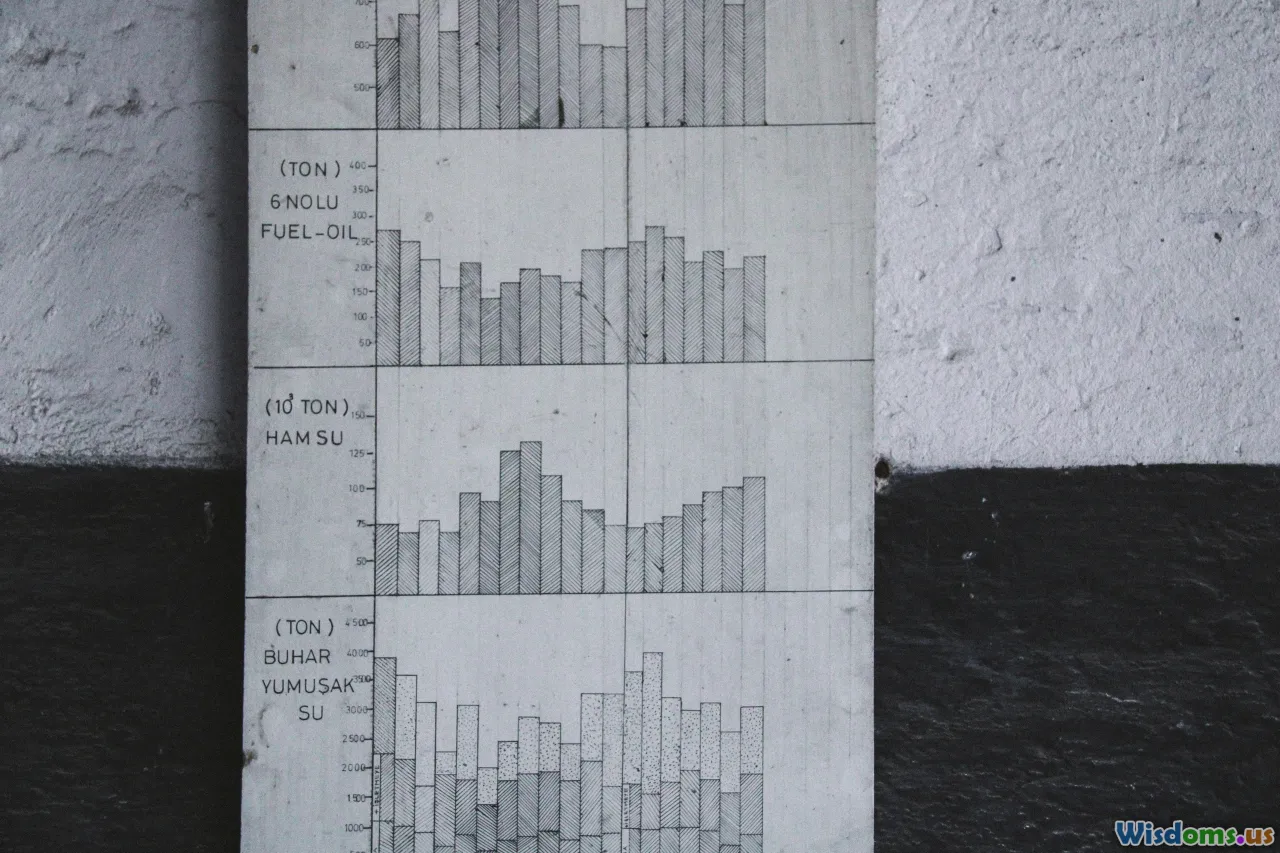

- Summary Table: Means, standard deviations for each group.

- ANOVA Table: F-statistic, degrees of freedom, p-value.

- Post hoc Findings: Clear statement on which means differ。

Effective Visualization Techniques:

- Boxplots: Show full score distributions per group—outliers included.

- Bar Charts with Error Bars: Visualize group means plus confidence intervals.

- Annotated Results: Mark statistically significant differences with asterisks or connecting lines。

Example Visualization (Matplotlib in Python):

import matplotlib.pyplot as plt

import seaborn as sns

sns.boxplot(x='Method', y='Score', data=df)

plt.title('Distribution of Scores by Teaching Method')

plt.show()

Well-made visuals don't just beautify work—they anchor business proposals, scientific publications, and actionable conclusions。

Tip: Always accompany numerical p-values with easy-to-understand visuals for non-technical readers—it makes your insights accessible and powerful!

From Analysis to Action: Making Decisions Based on ANOVA

The power of ANOVA is realized fully when its results drive improved practices. Statistical significance alone is only half the equation—what matters is the practical, real-world implication。

- Educational Reform: If your analysis confirms 'Interactive' teaching yields highest scores, consider reallocating resources to expand its implementation.

- Healthcare: If a new treatment outperforms control and existing therapies, it can justify broader clinical trials or updated patient protocols.

- Manufacturing: Identifying the most efficient process in a plant leads to cost savings and operational excellence。

Best Practices for Applying Findings:

- Align with Organizational Goals: Link ANOVA-backed recommendations to concrete outcomes (e.g., graduation rates, patient health, profit margins).

- Communicate Limitations: Be upfront about sample size limits, unmeasured confounders, and statistics-vs-practical difference.

- Suggest Next Steps: Sometimes, ANOVA answers one question but uncovers others—prompt further hypothesis and experimentation。

Case in Point: A retail chain's ANOVA reveals certain store layouts significantly boost sales. Management pilots the winning design across more locations, then re-evaluates quarterly—enacting a data-driven feedback loop.

Embracing this cycle—data cleaning, honest analysis, thorough reporting, and bold application—transforms raw numbers into a powerful narrative. Whether you’re optimizing resource allocation, improving patient outcomes, or simply striving to make better everyday decisions, the journey from raw data to ANOVA is your road to statistically-sound, strategically-brilliant action。

पोस्ट को रेट करें

उपयोगकर्ता समीक्षाएँ

सांख्यिकी विश्लेषण में अन्य पोस्ट

लोकप्रिय पोस्ट